使用爬虫技术最常见的API是httpclient和jsoup,当然jdk还有自带的爬虫API;下面介绍下两者的区别:

①HttpClient 是Apache Jakarta Common 下的子项目,可以用来提供高效的、最新的、功能丰富的支持 HTTP 协议((GET、POST、PUT、HEAD、DELETE、HEAD、OPTIONS 等))的客户端编程工具包,并且它支持 HTTP 协议最新的版本和建议。

HttpClient的主要功能:

1、实现了所有 HTTP 的方法

2、支持 HTTPS 协议

3、支持代理服务器(Nginx等)等

4、支持自动(跳转)转向②jsoup 是一款Java 的HTML解析器,可直接解析某个URL地址、HTML文本内容。它提供了一套非常省力的API,可通过DOM,CSS以及类似于jQuery的操作方法来取出和操作数据。

主要功能

从一个URL,文件或字符串中解析HTML使用DOM或CSS选择器来查找、取出数据使用DOM或CSS选择器来查找、取出数据可操作HTML元素、属性、文本可操作HTML元素、属性、文本。总而言之,使用httpclient进行网络爬虫获取到的数据无法进行解析,而jsoup自带解析器,能够更加方便的获取想要的数据。

上手实践:

使用Java中jdk自带的API

导入相关依赖

HttpClient 的使用

jsoup的使用:

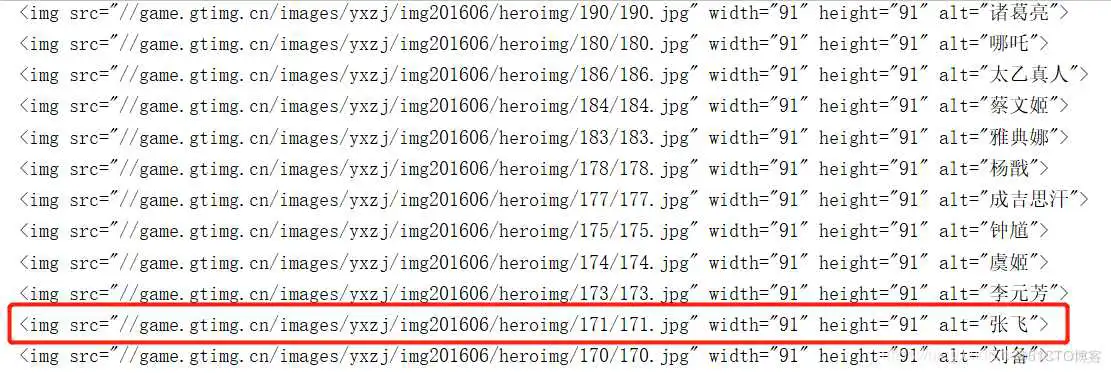

这里使用jsoup获取腾讯王者荣耀皮肤,获取到的是网址地址。

访问上面标红的网址,如下:

当然我们也可以使用连接池创建,关注我下期带你使用连接池。

到此这篇java爬虫视频教程(java爬虫入门)的文章就介绍到这了,更多相关内容请继续浏览下面的相关推荐文章,希望大家都能在编程的领域有一番成就!版权声明:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权、违法违规、事实不符,请将相关资料发送至xkadmin@xkablog.com进行投诉反馈,一经查实,立即处理!

转载请注明出处,原文链接:https://www.xkablog.com/jjc/80454.html