目录

1.elasticsearch-6.2.2 (存储日志数据)

三、修改每个java微服务的logback-spring.xml 日志文件

前言:由于项目是使用spring cloud搭建的。项目前期没有搭建elk日志系统,结果正式环境需要查看很久之前的日志很不方便,而且服务器上的日志只保留了1个月,再追溯之前的日志就无处可寻了。本来该再项目初期就搭建elk日志管理的。奈何我是项目中期才加入进来。所以需要单独再搭建一下。

一、安装前准备

elastic官网:

https://www.elastic.co/cn/downloads1.elasticsearch-6.2.2 (存储日志数据)

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-6.2.2.tar.gz2.logstash-6.2.2(收集日志数据)

wget https://artifacts.elastic.co/downloads/logstash/logstash-6.2.2.tar.gz3.kibana-6.2.2(显示日志数据)

wget https://artifacts.elastic.co/downloads/kibana/kibana-6.2.2-linux-x86_64.tar.gz

二、开始安装

1.elasticsearch 安装

参考我之前的博客:spring cloud搭建elk

2.logstash 安装

(1)解压安装包

tar -zxvf logstash-6.2.2.tar.gz(2)测试安装是否成功

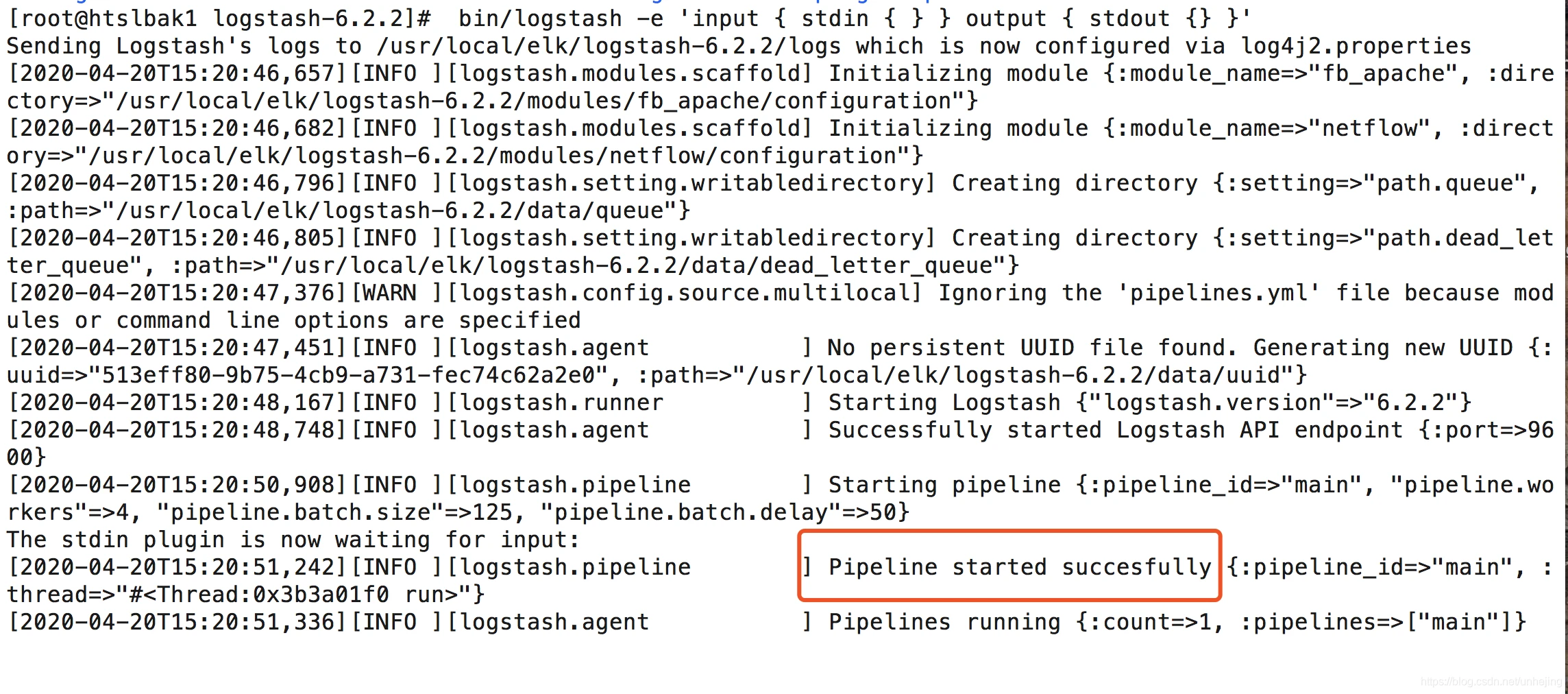

bin/logstash -e 'input{stdin{}}output{stdout{codec=>rubydebug}}'

显示 Pipeline started succesfully即表示成功。

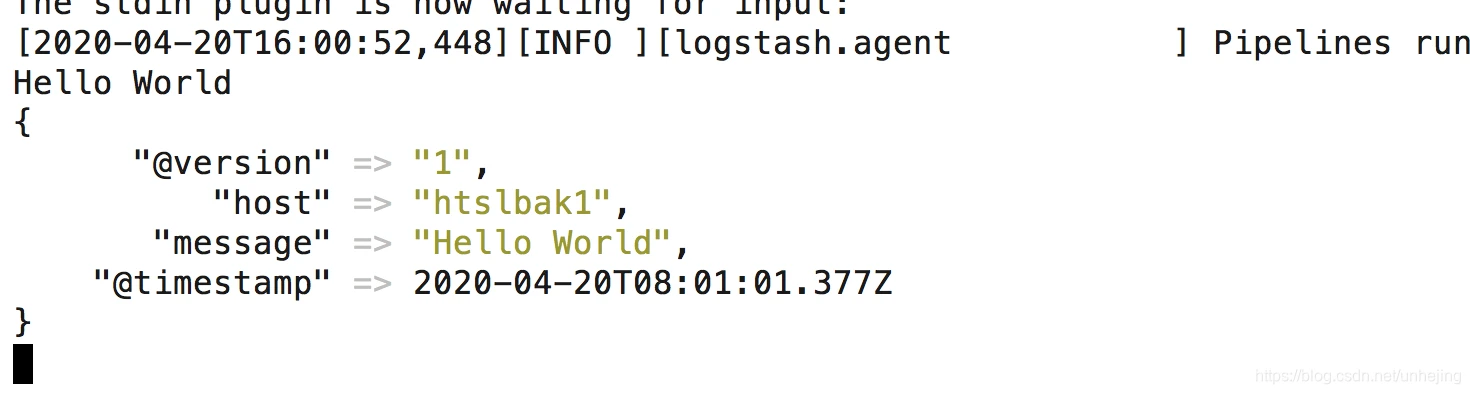

然后你会发现终端在等待你的输入。敲入 Hello World,回车,结果如图:

(3)配置logstash将日志输出到elasticsearch

--修改logstash配置文件

cd logstash-6.2.2/config/ vim logstash.conf 创建配置文件并输入以下配置:

input { tcp { port => 4560 codec => "json" } } output { elasticsearch { hosts => ["localhost:9200"] index => "%{[appname]}" } stdout { codec => rubydebug } } --配置文件说明:

其中port为端口号,codec表示数据为json格式传输,elasticsearch.hosts表示elasticsearch的地址,index为日志在的elasticsearch存储的索引。appname配置就是获取日志中的 appname字段的值做为索引的名称

--启动

带配置文件启动,进程不能退出,调试的时候使用。

bin/logstash -f logstash.conf后台启动(输入全路径):

nohup /usr/local/elk/logstash-6.2.2/bin/logstash -f /usr/local/elk/logstash-6.2.2/config/logstash.conf > /var/log/logstash/logstash.log 2>&1 &3.kibana 安装

(1)解压安装包

tar -zxvf kibana-6.2.2-linux-x86_64.tar.gz (2)修改配置文件

cd kibana-6.2.2-linux-x86_64/config/ vim kibana.yml 修改配置:

# 端口 server.port: 5601 # 指定本机ip让外部能访问 server.host: "0.0.0.0" # 请求数据指向的elasticsearch服务器 elasticsearch.url: "http://192.168.31.53:9200" 进入bin目录启动:

sh kibana &后台启动:

nohup bin/kibana &

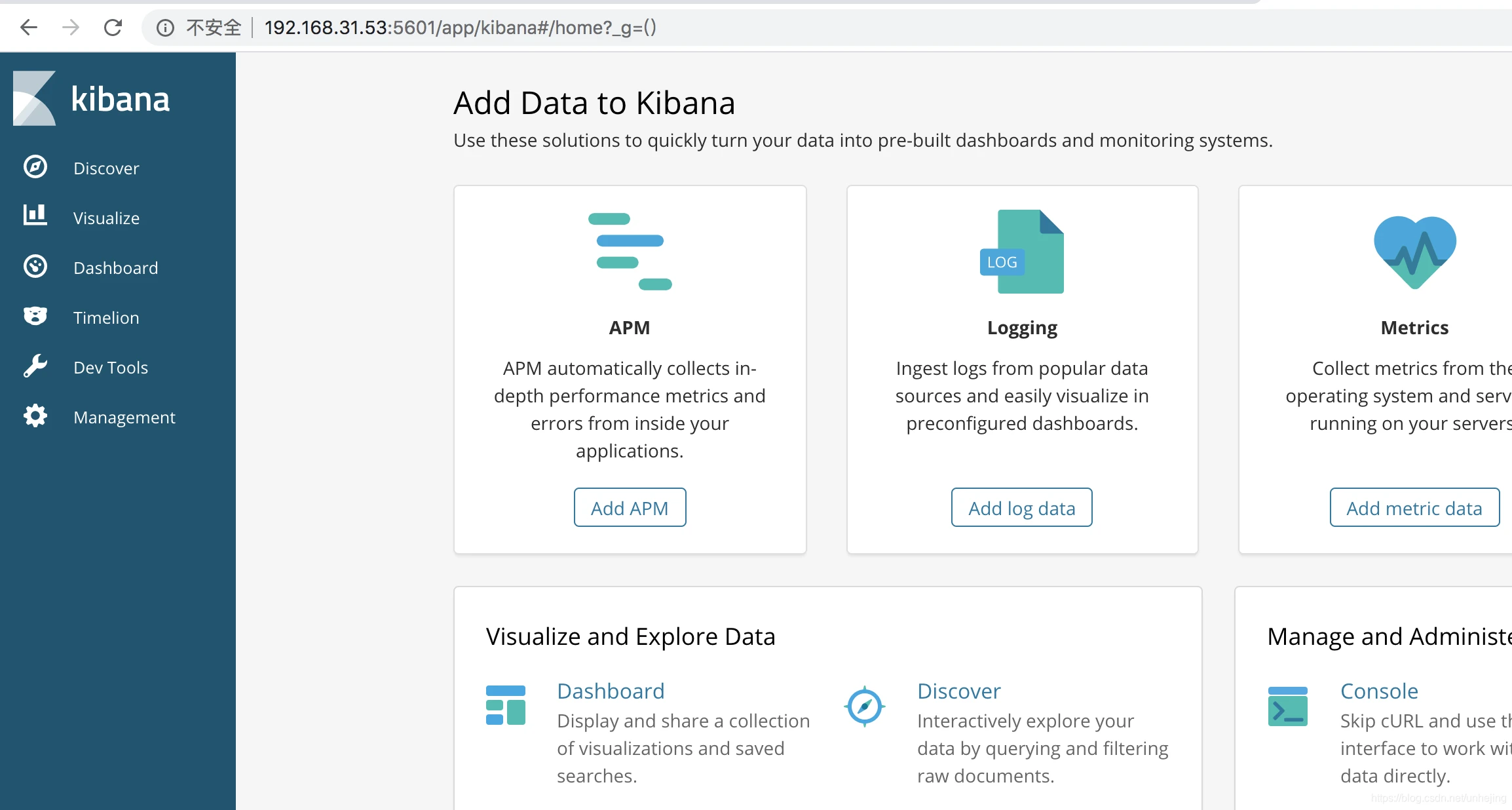

在浏览器输入:ip:5601访问,如图:

综上:服务器端的elk配置搭建成功,接下来需要配置spring cloud的日志文件,使之产生的日志能发送到elasticsearch上储存。

三、修改每个java微服务的logback-spring.xml 日志文件

--在原日志文件的基础上添加如下代码(前提项目已logback-spring.xml为日志配置文件):

<!--logstash配置--> <appender name="STASH_PRO" class="net.logstash.logback.appender.LogstashTcpSocketAppender"> <destination>192.168.11.53:4560</destination> <!-- 编码器 --> <encoder class="net.logstash.logback.encoder.LogstashEncoder"> <providers> <timestamp> <timeZone>UTC</timeZone> </timestamp> <pattern> <pattern> { "severity":"%level", "service": "${springAppName:-}", "trace": "%X{X-B3-TraceId:-}", "span": "%X{X-B3-SpanId:-}", "exportable": "%X{X-Span-Export:-}", "pid": "${PID:-}", "thread": "%thread", "class": "%logger{50}", "rest": "%message" } </pattern> </pattern> </providers> <!-- 索引名--> <customFields>{"appname":"hty-b2c-service"}</customFields> </encoder> </appender> <!-- 生产环境:输出到文件--> <springProfile name="pro"> <root level="info"> <appender-ref ref="DEBUG_FILE" /> <appender-ref ref="INFO_FILE" /> <appender-ref ref="ERROR_FILE" /> <appender-ref ref="WARN_FILE" /> <appender-ref ref="STASH_PRO" /> </root> <root level="error"> <appender-ref ref="ERROR_FILE" /> </root> <root level="warn"> <appender-ref ref="WARN_FILE" /> </root> <root level="debug"> <appender-ref ref="DEBUG_FILE"/> </root> </springProfile>--pom文件引入依赖:

<dependency> <groupId>net.logstash.logback</groupId> <artifactId>logstash-logback-encoder</artifactId> <version>4.11</version> </dependency>然后再重启java微服务。

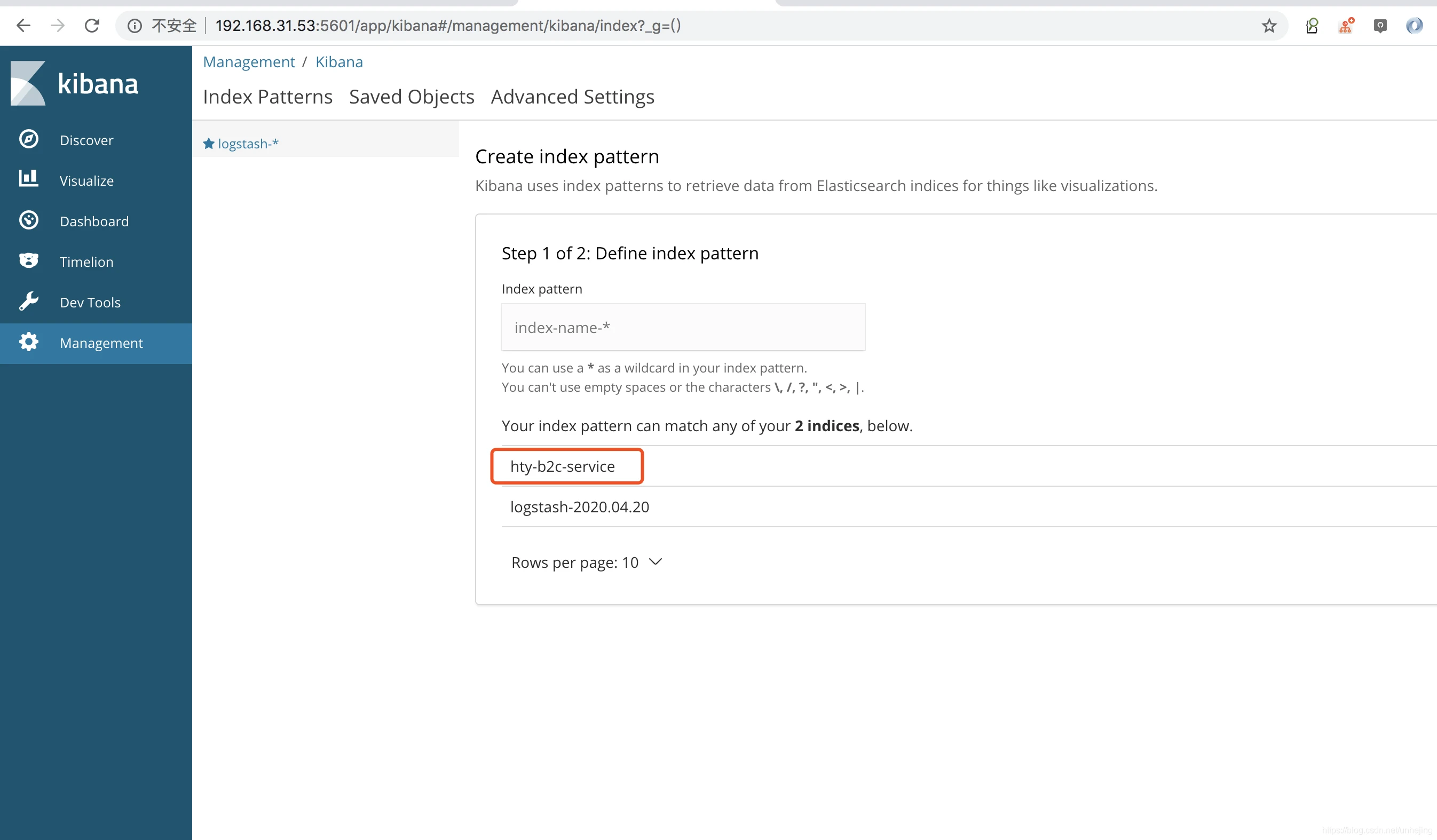

成功的截图,es自动创建了服务的索引,接下来就是kibana的一些查询操作了。

文章末尾附上一份完整的logback.xml配置文件:

<?xml version="1.0" encoding="UTF-8"?> <configuration debug="false"> <springProperty scope="context" name="springAppName" source="spring.application.name" /> <!--web信息 --> <include resource="org/springframework/boot/logging/logback/base.xml" /> <property name="LOG_PATH" value="${user.dir}/logs/b2c"/> <!-- 彩色日志 --> <!-- 彩色日志依赖的渲染类 --> <conversionRule conversionWord="clr" converterClass="org.springframework.boot.logging.logback.ColorConverter" /> <conversionRule conversionWord="wex" converterClass="org.springframework.boot.logging.logback.WhitespaceThrowableProxyConverter" /> <conversionRule conversionWord="wEx" converterClass="org.springframework.boot.logging.logback.ExtendedWhitespaceThrowableProxyConverter" /> <!-- 彩色日志格式 --> <!--<property name="CONSOLE_LOG_PATTERN" value="${CONSOLE_LOG_PATTERN:-%clr(%d{yyyy-MM-dd HH:mm:ss.SSS}){faint} %clr(${LOG_LEVEL_PATTERN:-%5p}) %clr(${PID:- }){magenta} %clr(---){faint} %clr([%15.15t]){faint} %clr(%-40.40logger{39}){cyan} %clr(:){faint} %m%n${LOG_EXCEPTION_CONVERSION_WORD:-%wEx}}"/>--> <property name="CONSOLE_LOG_PATTERN" value="${CONSOLE_LOG_PATTERN:-%clr(%d{yyyy-MM-dd HH:mm:ss.SSS}){faint} %clr(${LOG_LEVEL_PATTERN:-%5p}) %clr(${PID:- }){magenta} %clr(---){faint} %clr([%15.15t]){faint} %clr(%-40.40logger{39}){cyan} %clr(%X{X-B3-TraceId:-}){cyan} %clr(%X{X-B3-SpanId:-}){cyan} %clr(:){faint} %m%n${LOG_EXCEPTION_CONVERSION_WORD:-%wEx}}"/> <!--输出到控制台--> <appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender"> <!--此日志appender是为开发使用,只配置最底级别,控制台输出的日志级别是大于或等于此级别的日志信息--> <filter class="ch.qos.logback.classic.filter.ThresholdFilter"> <level>info</level> </filter> <encoder> <Pattern>${CONSOLE_LOG_PATTERN}</Pattern> <!-- 设置字符集 --> <charset>UTF-8</charset> </encoder> </appender> <!--输出到文件--> <!-- 时间滚动输出 level为 DEBUG 日志 --> <appender name="DEBUG_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender"> <!-- 正在记录的日志文件的路径及文件名 --> <!-- <file>${LOG_PATH}/log_debug.log</file>--> <!--日志文件输出格式--> <encoder> <pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern> <charset>UTF-8</charset> <!-- 设置字符集 --> </encoder> <!-- 日志记录器的滚动策略,按日期,按大小记录 --> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <!-- 日志归档 --> <fileNamePattern>${LOG_PATH}/debug/log-debug-%d{yyyy-MM-dd}.%i.log</fileNamePattern> <timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP"> <maxFileSize>100MB</maxFileSize> </timeBasedFileNamingAndTriggeringPolicy> <!--日志文件保留天数--> <maxHistory>30</maxHistory> </rollingPolicy> <!-- 此日志文件只记录debug级别的 --> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>debug</level> <onMatch>ACCEPT</onMatch> <onMismatch>DENY</onMismatch> </filter> </appender> <!-- 时间滚动输出 level为 INFO 日志 --> <appender name="INFO_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender"> <!-- 正在记录的日志文件的路径及文件名 --> <!-- <file>${LOG_PATH}/log_info.log</file>--> <!--日志文件输出格式--> <encoder> <pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern> <charset>UTF-8</charset> </encoder> <!-- 日志记录器的滚动策略,按日期,按大小记录 --> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <!-- 每天日志归档路径以及格式 --> <fileNamePattern>${LOG_PATH}/info/log-info-%d{yyyy-MM-dd}.%i.log</fileNamePattern> <timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP"> <maxFileSize>100MB</maxFileSize> </timeBasedFileNamingAndTriggeringPolicy> <!--日志文件保留天数--> <maxHistory>30</maxHistory> </rollingPolicy> <!-- 此日志文件只记录info级别的 --> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>info</level> <onMatch>ACCEPT</onMatch> <onMismatch>DENY</onMismatch> </filter> </appender> <!-- 时间滚动输出 level为 WARN 日志 --> <appender name="WARN_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender"> <!-- 正在记录的日志文件的路径及文件名 --> <!-- <file>${LOG_PATH}/log_warn.log</file>--> <!--日志文件输出格式--> <encoder> <pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern> <charset>UTF-8</charset> <!-- 此处设置字符集 --> </encoder> <!-- 日志记录器的滚动策略,按日期,按大小记录 --> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <fileNamePattern>${LOG_PATH}/warn/log-warn-%d{yyyy-MM-dd}.%i.log</fileNamePattern> <timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP"> <maxFileSize>100MB</maxFileSize> </timeBasedFileNamingAndTriggeringPolicy> <!--日志文件保留天数--> <maxHistory>30</maxHistory> </rollingPolicy> <!-- 此日志文件只记录warn级别的 --> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>warn</level> <onMatch>ACCEPT</onMatch> <onMismatch>DENY</onMismatch> </filter> </appender> <!-- 时间滚动输出 level为 ERROR 日志 --> <appender name="ERROR_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender"> <!-- 正在记录的日志文件的路径及文件名 --> <!-- <file>${LOG_PATH}/log_error.log</file>--> <!--日志文件输出格式--> <encoder> <pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern> <charset>UTF-8</charset> <!-- 此处设置字符集 --> </encoder> <!-- 日志记录器的滚动策略,按日期,按大小记录 --> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <fileNamePattern>${LOG_PATH}/error/log-error-%d{yyyy-MM-dd}.%i.log</fileNamePattern> <timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP"> <maxFileSize>100MB</maxFileSize> </timeBasedFileNamingAndTriggeringPolicy> <!--日志文件保留天数--> <maxHistory>30</maxHistory> </rollingPolicy> <!-- 此日志文件只记录ERROR级别的 --> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>error</level> <onMatch>ACCEPT</onMatch> <onMismatch>DENY</onMismatch> </filter> </appender> <!--logstash配置--> <appender name="STASH_PRO" class="net.logstash.logback.appender.LogstashTcpSocketAppender"> <destination>192.168.31.53:4560</destination> <!-- 编码器 --> <encoder class="net.logstash.logback.encoder.LogstashEncoder"> <providers> <timestamp> <timeZone>UTC</timeZone> </timestamp> <pattern> <pattern> { "severity":"%level", "service": "${springAppName:-}", "trace": "%X{X-B3-TraceId:-}", "span": "%X{X-B3-SpanId:-}", "exportable": "%X{X-Span-Export:-}", "pid": "${PID:-}", "thread": "%thread", "class": "%logger{40}", "rest": "%message" } </pattern> </pattern> </providers> <!-- 索引名--> <customFields>{"appname":"hty-b2c-service"}</customFields> </encoder> </appender> <!-- <logger>用来设置某一个包或者具体的某一个类的日志打印级别、 以及指定<appender>。<logger>仅有一个name属性, 一个可选的level和一个可选的addtivity属性。 name:用来指定受此logger约束的某一个包或者具体的某一个类。 level:用来设置打印级别,大小写无关:TRACE, DEBUG, INFO, WARN, ERROR, ALL 和 OFF, 还有一个特俗值INHERITED或者同义词NULL,代表强制执行上级的级别。 如果未设置此属性,那么当前logger将会继承上级的级别。 addtivity:是否向上级logger传递打印信息。默认是true。 --> <!--<logger name="org.springframework.web" level="info"/>--> <!--<logger name="org.springframework.scheduling.annotation.ScheduledAnnotationBeanPostProcessor" level="INFO"/>--> <!-- 使用mybatis的时候,sql语句是debug下才会打印,而这里我们只配置了info,所以想要查看sql语句的话,有以下两种操作: 第一种把<root level="info">改成<root level="DEBUG">这样就会打印sql,不过这样日志那边会出现很多其他消息 第二种就是单独给dao下目录配置debug模式,代码如下,这样配置sql语句会打印,其他还是正常info级别: --> <!-- root节点是必选节点,用来指定最基础的日志输出级别,只有一个level属性 level:用来设置打印级别,大小写无关:TRACE, DEBUG, INFO, WARN, ERROR, ALL 和 OFF, 不能设置为INHERITED或者同义词NULL。默认是DEBUG 可以包含零个或多个元素,标识这个appender将会添加到这个logger。 --> <!--开发环境:打印控制台--> <springProfile name="dev"> <logger name="com.hty.b2c.mapper" level="debug"/> </springProfile> <root level="info"> <!-- <appender-ref ref="CONSOLE" />--> <appender-ref ref="DEBUG_FILE" /> <appender-ref ref="INFO_FILE" /> <appender-ref ref="WARN_FILE" /> <appender-ref ref="ERROR_FILE" /> </root> <!-- 生产环境:输出到文件--> <springProfile name="pro"> <root level="info"> <!-- <appender-ref ref="CONSOLE" />--> <appender-ref ref="DEBUG_FILE" /> <appender-ref ref="INFO_FILE" /> <appender-ref ref="ERROR_FILE" /> <appender-ref ref="WARN_FILE" /> <appender-ref ref="STASH_PRO" /> </root> <root level="error"> <appender-ref ref="ERROR_FILE" /> </root> <root level="warn"> <appender-ref ref="WARN_FILE" /> </root> <root level="debug"> <appender-ref ref="DEBUG_FILE"/> </root> </springProfile> </configuration>备注:如果博客中有任何问题或者您下载安装包太慢,需要作者的安装包都可以关注公众号FOSSspace联系我哟。

到此这篇spring cloud搭建elk的文章就介绍到这了,更多相关内容请继续浏览下面的相关推荐文章,希望大家都能在编程的领域有一番成就!版权声明:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权、违法违规、事实不符,请将相关资料发送至xkadmin@xkablog.com进行投诉反馈,一经查实,立即处理!

转载请注明出处,原文链接:https://www.xkablog.com/rfx/10605.html